四,部署Nutanix-CE虚拟主机

通过以上准备工作,现在可以正式开始Nutanix-CE的部署工作

4.1上传安装文件

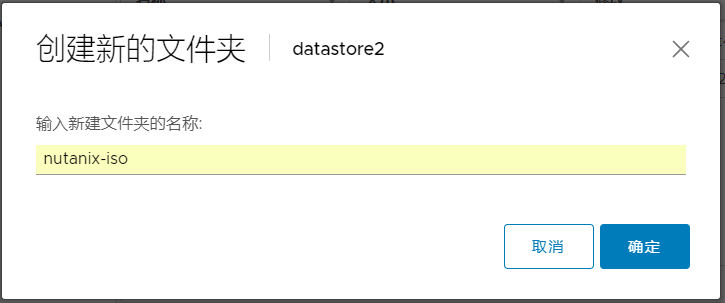

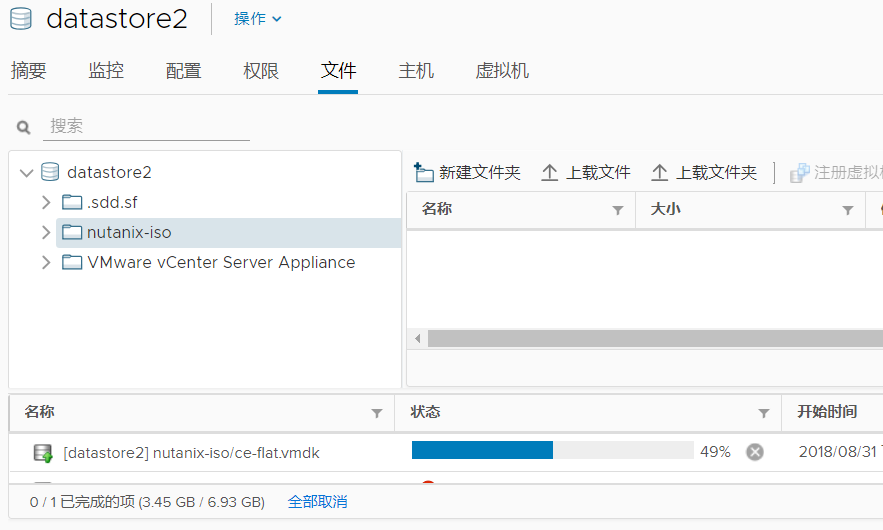

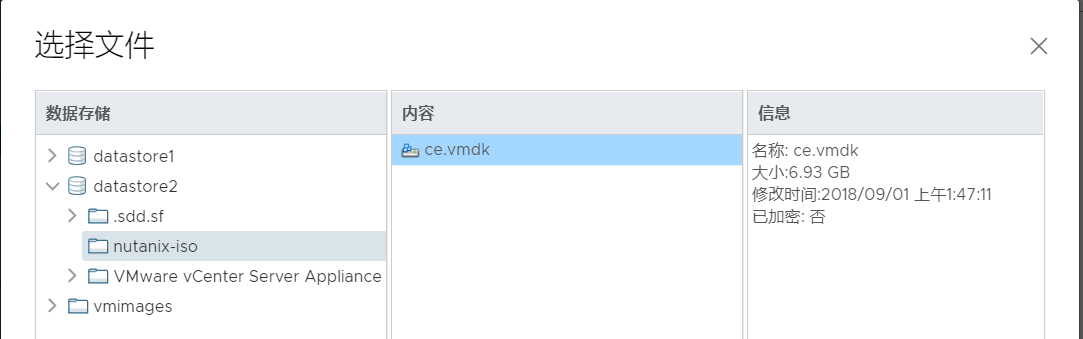

这里我们将安装文件上传到datastore2中,新建一个文件夹“nutanix-iso“, 然后将安装文件上传进去。

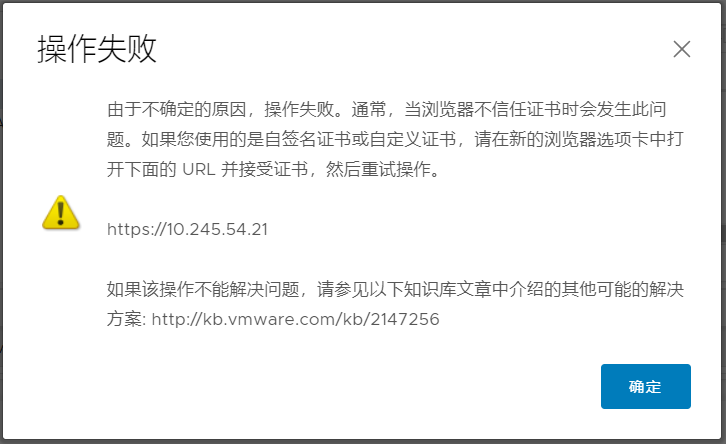

如果提示上传失败,需要在浏览器中再次打开一下ESXi,并添加例外

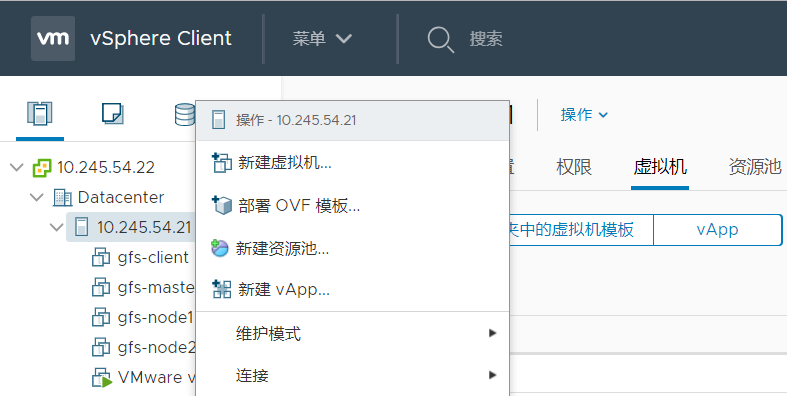

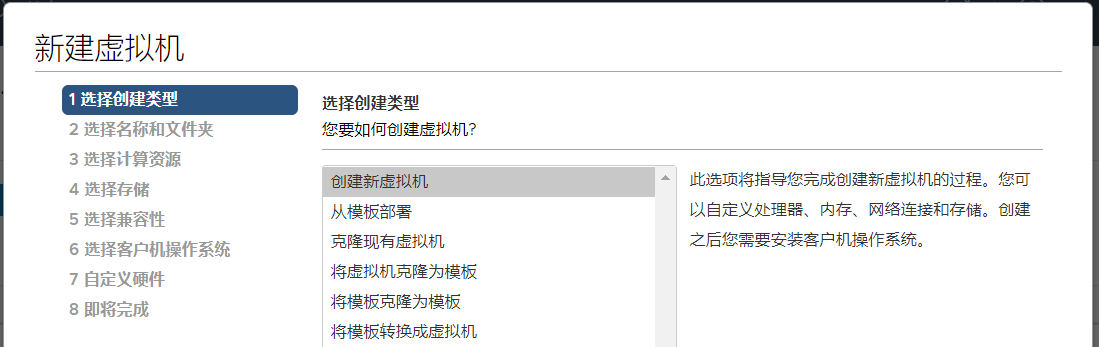

4.2 创建Nutanix-CE Host虚拟机

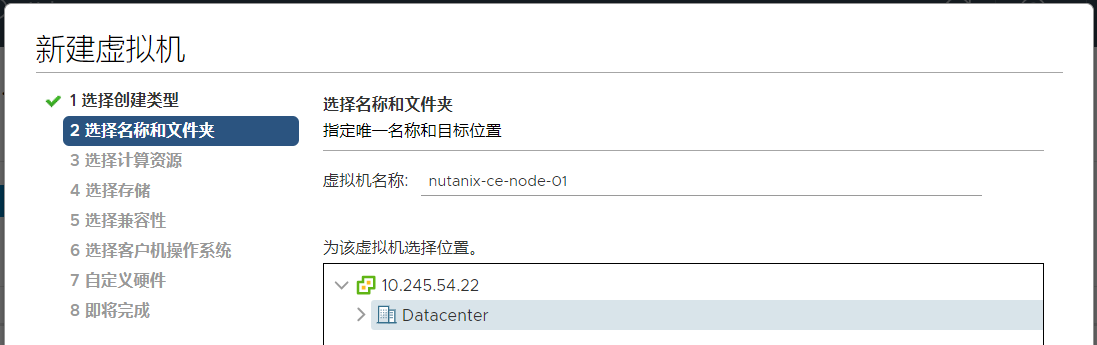

安装文件上传完成后,开始创建虚拟机的工作。这里我们先创建一个虚拟机,命名为“nutanix-ce-node-01“

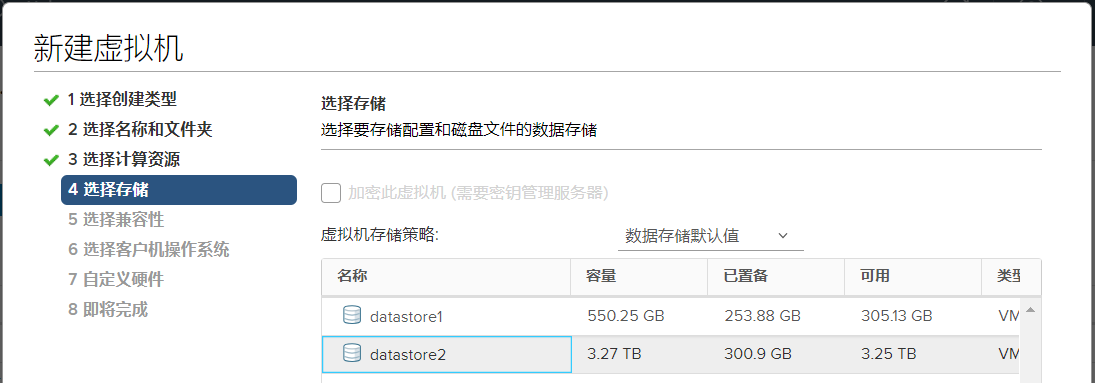

数据存储我们选择空间大的“datastore2“

设置CPU数量,勾选“向客户机操作系统公开硬件辅助虚拟化”选项

设置内存容量,最少16GB,经过反复测试后发现,如果内存容量小于16GB,创建集群时有的主机会停止响应,导致创建失败。

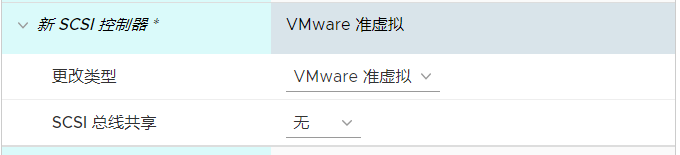

将新SCSI控制器类型改为“VMware准虚拟”

将原有的硬盘删除,添加新硬盘时选择“现有硬盘”

“现有硬盘”我们选择前面上传的nutanix-ce的磁盘文件ce.vmdk

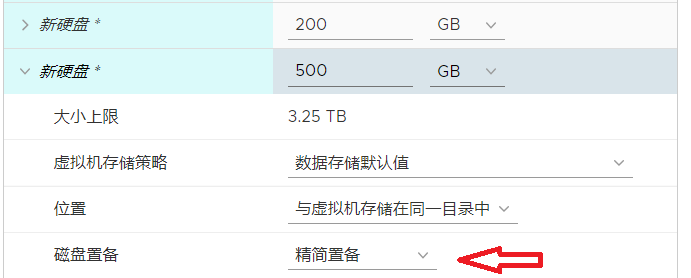

再添加两块硬盘,选择“新硬盘”,容量分别为200GB和500GB。如果磁盘容量有限或想节约容量,请选择“精简配置”。其中,我们将使用200GB的硬盘来模拟SSD。500G的硬盘为HDD。这样才会符合硬件最低配置要求。

确认配置正确后,点击“完成”生成虚拟机。新虚拟机创建完毕后,先不要开机,下一步我们要基于新建的虚拟机快克隆出其它几台节点

4.3 克隆虚拟机

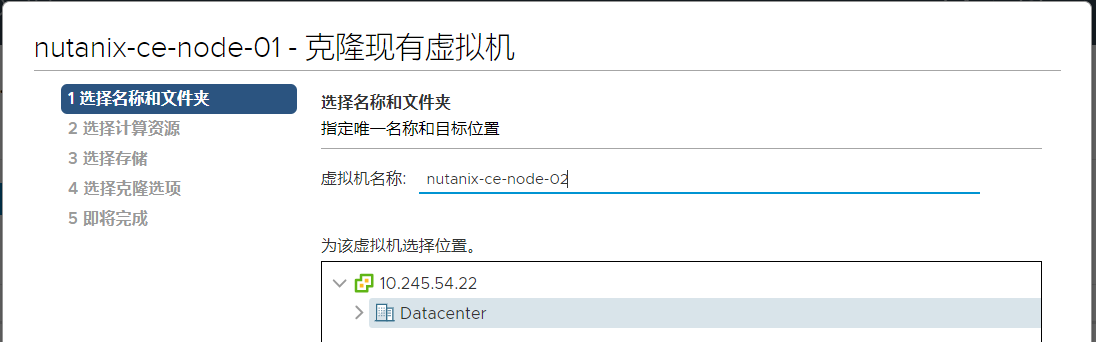

右键点击上一步创建的虚拟机,选择“克隆”—“克隆到虚拟机”,修改名称。

数据存储仍然选择datastore2,其它设置保持默认即可。我们一共克隆出3台nutanix-ce host虚拟机,分别命名为:nutanix-ce-node-02、 nutanix-ce-node-03、nutanix-ce-node-04。

克隆工作完成以后,nutanix-ce host虚拟机的创建工作就完成了,我们一共有4台host虚拟机,我们使用前三台来创建集群。 然后用第四台来演示集群扩容。

五,部署Nutanix-CE

5.1 登陆虚拟机

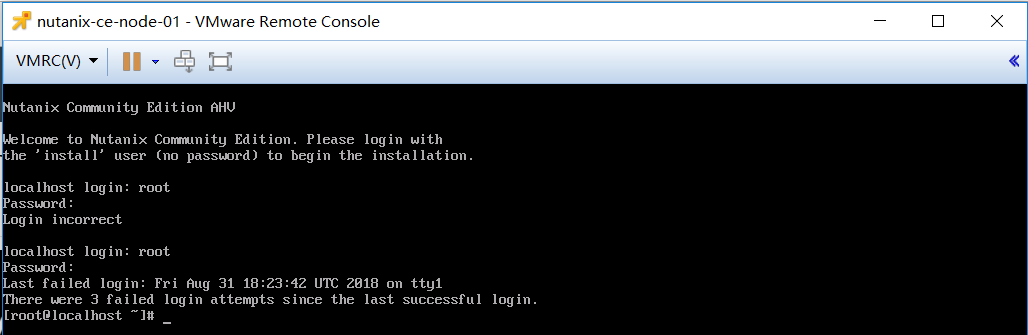

这里我们选址登陆第一台虚拟机“nutanix-ce-node-01”,以SSH方式登陆。可以使用web方式打开控制台,也可以用VMRC,也可以使用xshell等工具登陆。先将第一台VM上电开机。使用root用户登陆。

5.2 修改 Nutanix-CE 配置文件

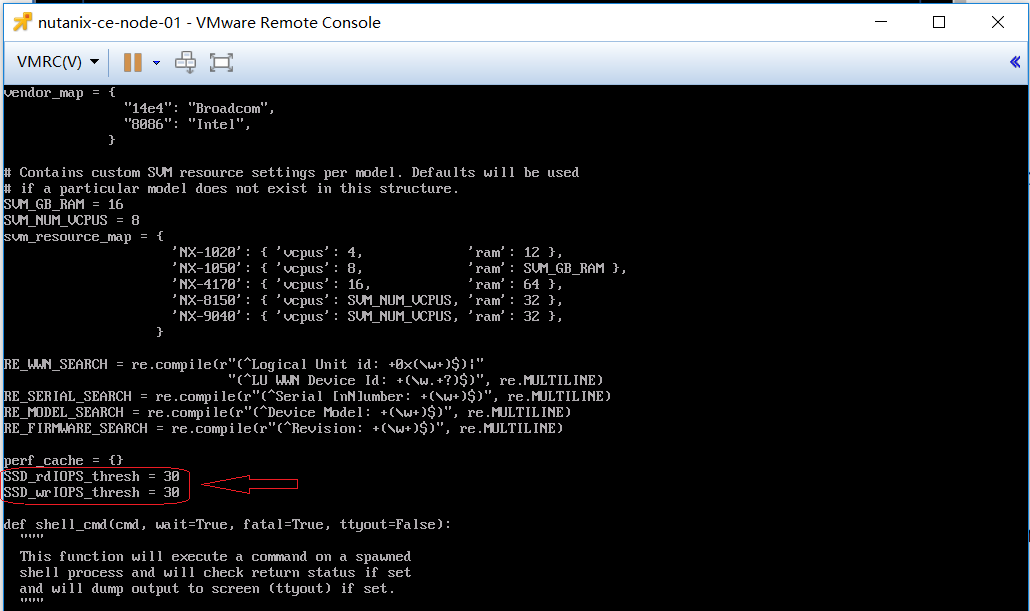

5.2.1 修改sysUtil.py

在本次测试中,由于我们是使用HDD来模拟SSD,所以需要更改安装配置文件中的 SSD IOPS 参数。这个参数可以根据服务器实际性能来设置。只要能通过安装过程中的检测就可以。这里我将IOPS值改为30。文件路径如下:

/home/install/phx_iso/phoenix/sysUtil.py

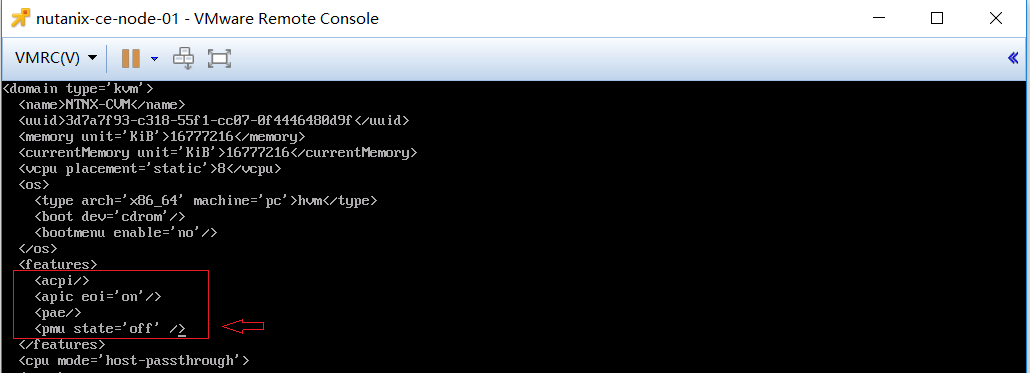

5.2.2 修改default.xml

文件路径:/home/install/phx_iso/phoenix/svm_template/kvm/default.xml

如下图,增加一行: 禁用性能监控单元

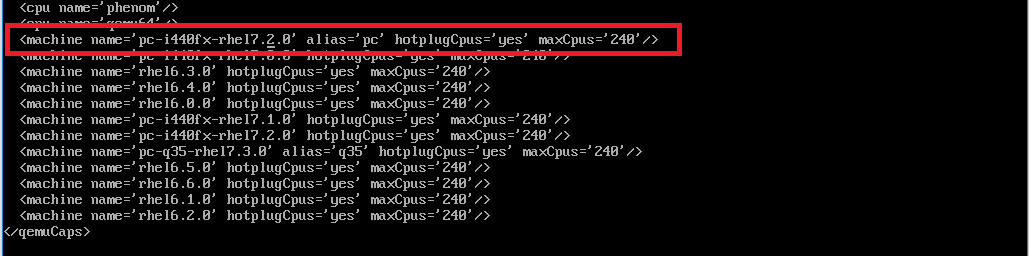

5.2.3 修改uuid.xml

文件路径: /var/cache/libvirt/qemu/capabilities/

将xml文件中的rhel7.3.0 改为 rhel7.2.0

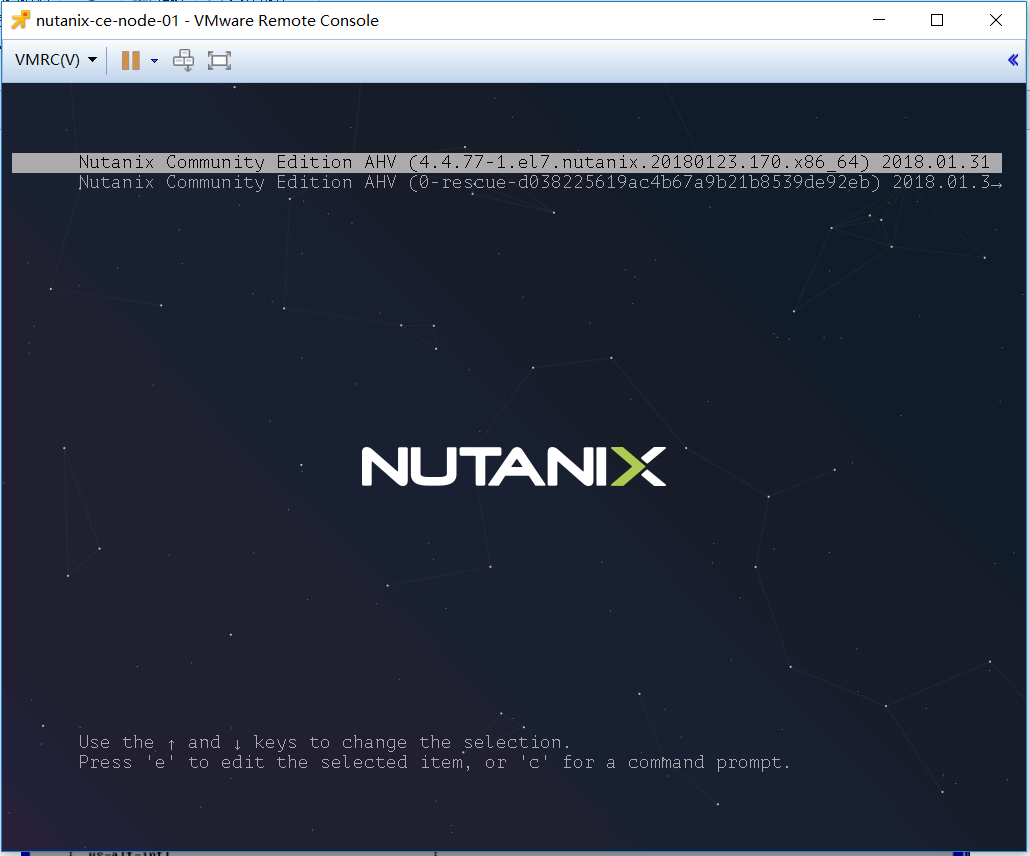

5.2.4 重启host虚拟机

所有配置文件修改完成后,重启虚拟机

5.3 开始部署

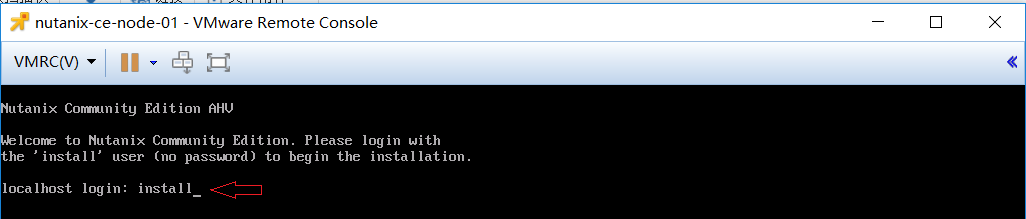

5.3.1 使用install进行部署

在登陆界面,输入install启动部署

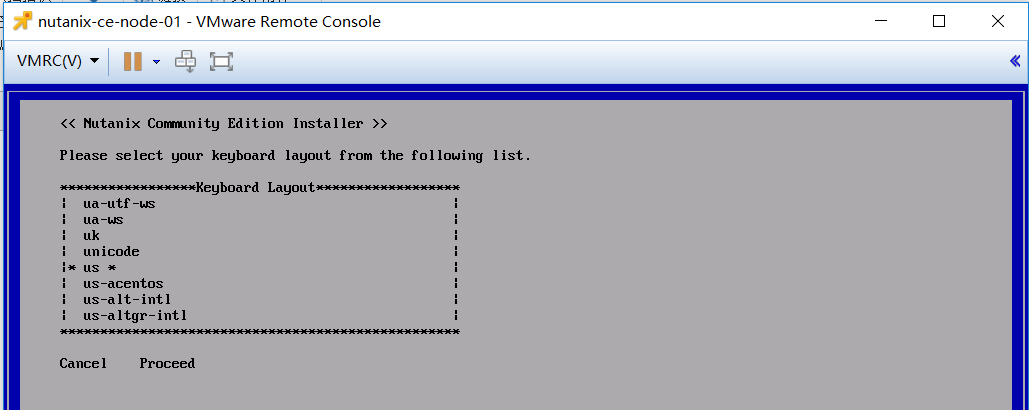

5.3.2 键盘布局

选择键盘布局格式,默认即可

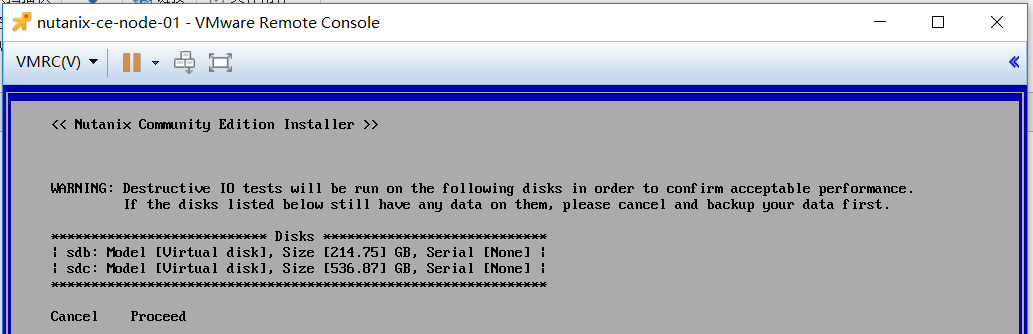

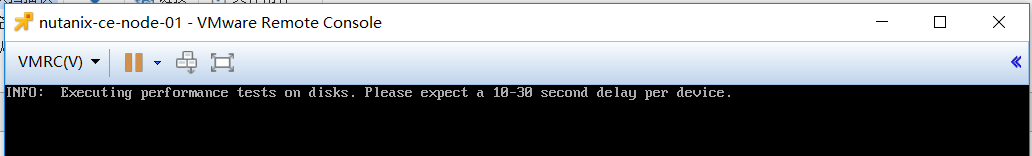

5.3.3 IO性能检测

开始测试磁盘的 IOPS,这里参照的性能值,就是我们修改的第一个配置文件,如果测试不通过,安装将被取消。可以修改配置文件,将IOPS值改小一些再进行安装。

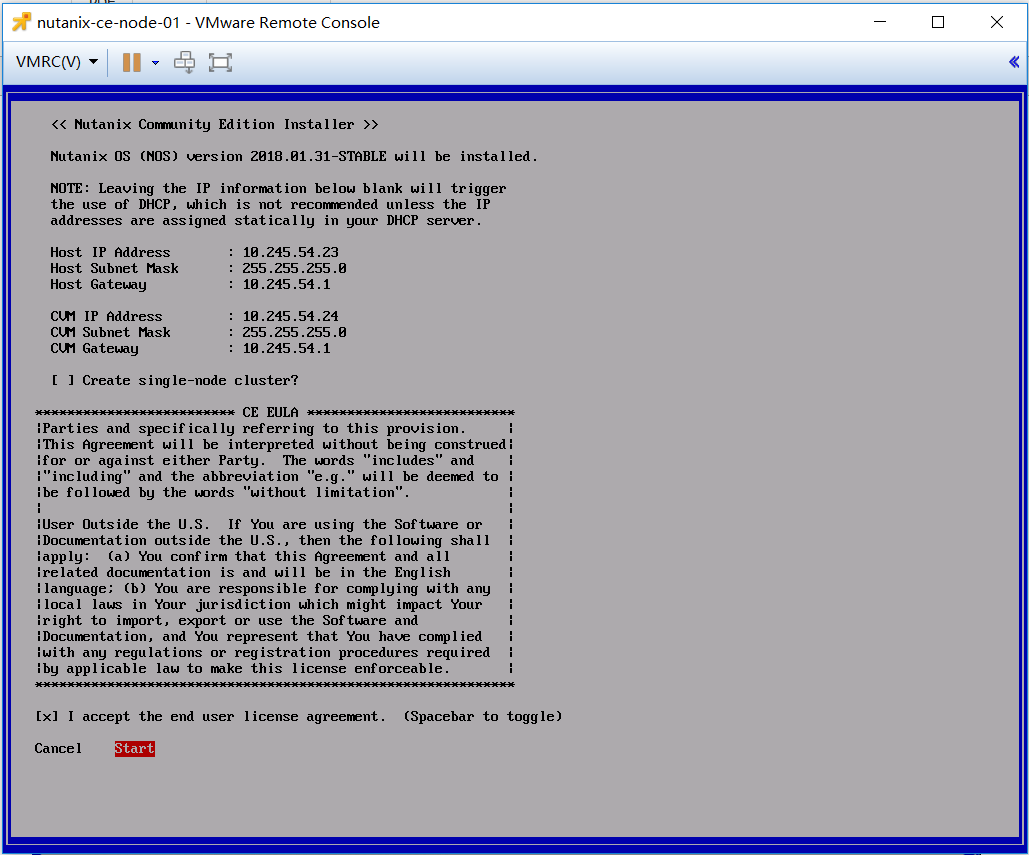

5.3.4 填写IP地址信息

按规划填写HOST IP和 CVM IP地址信息。Host IP 就是AHV的IP。

注意:如果是部署单节点集群,这个集群将不允许扩容。这里我们不选择此选项。另外,EULA 最终用户许可协议这里,一定要将协议滚动到最后再勾选“接受”,如果直接勾选“接受”安装程序将报错终止。

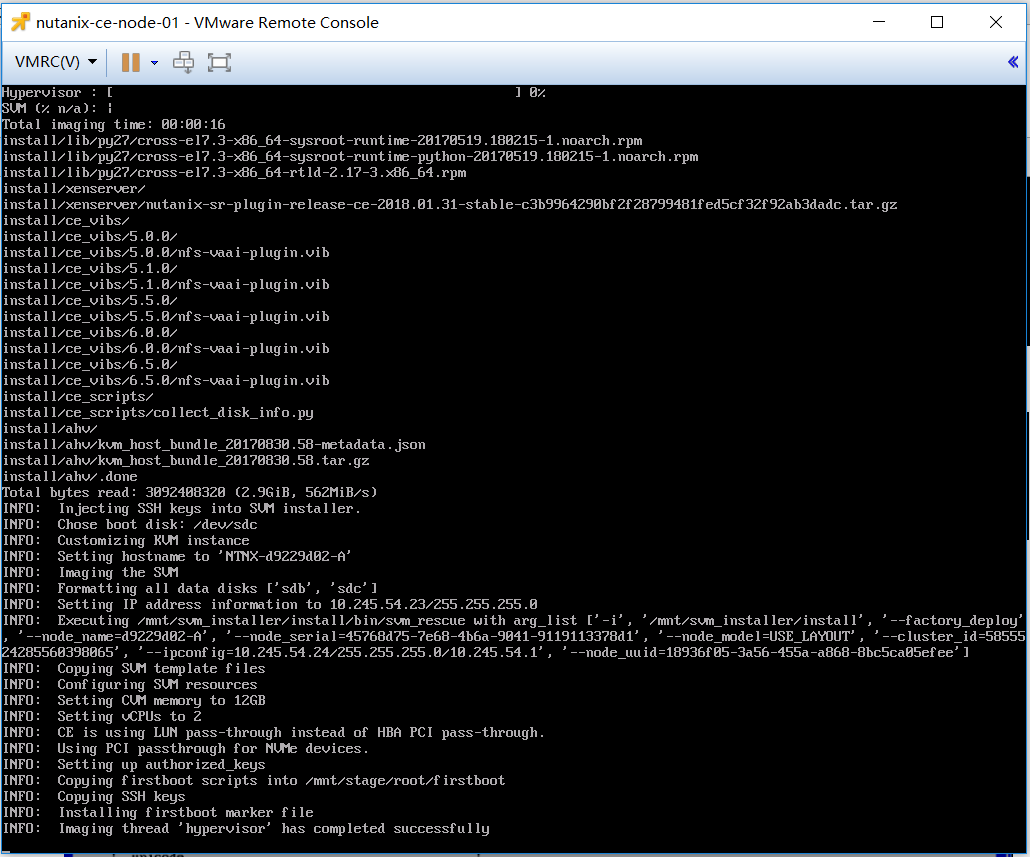

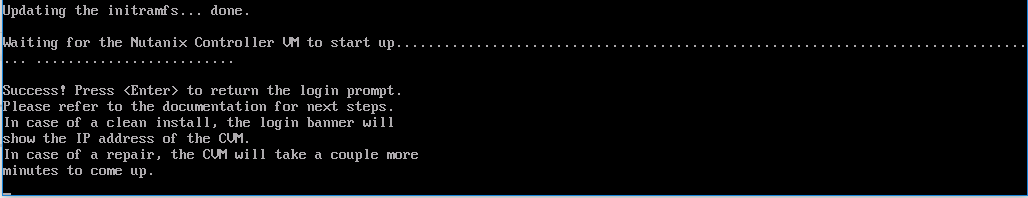

5.3.5 等待部署完成

点击“start”开始部署,根据服务器性能不同,部署时间会有区别,在我这个测试中,部署耗时约6分钟。

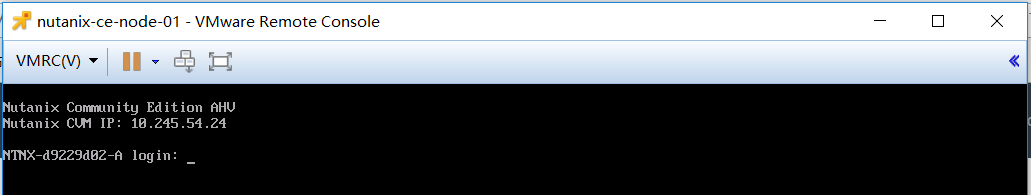

看到如下提示后,表示部署成功。按“回车”继续,返回到登陆界面

5.4 部署其它节点

以相同的方式部署“nutanix-ce-node-02”和“nutanix-ce-node-03”。

5.5 节点健康状态检查

主要检查网络状态,登陆各个host节点,确认各节点的CVM可以相互ping通

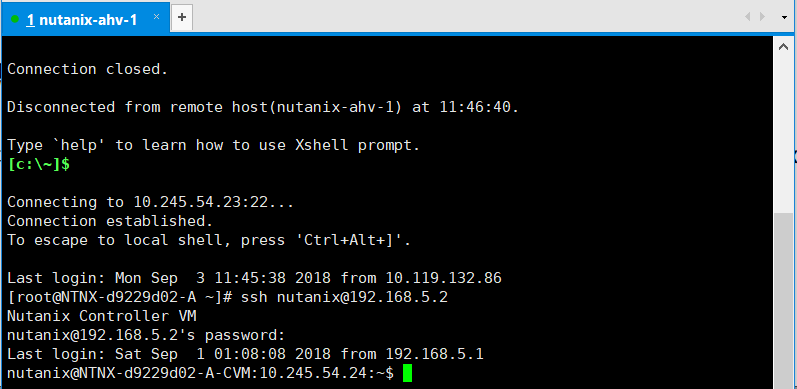

5.5.1登陆到CVM

通过CVM内部IP地址进行登录。ssh nutanix@192.168.5.2

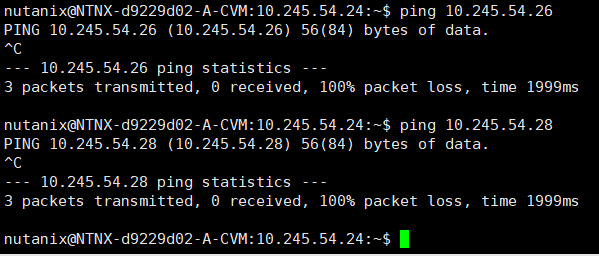

5.5.2 ping CVM

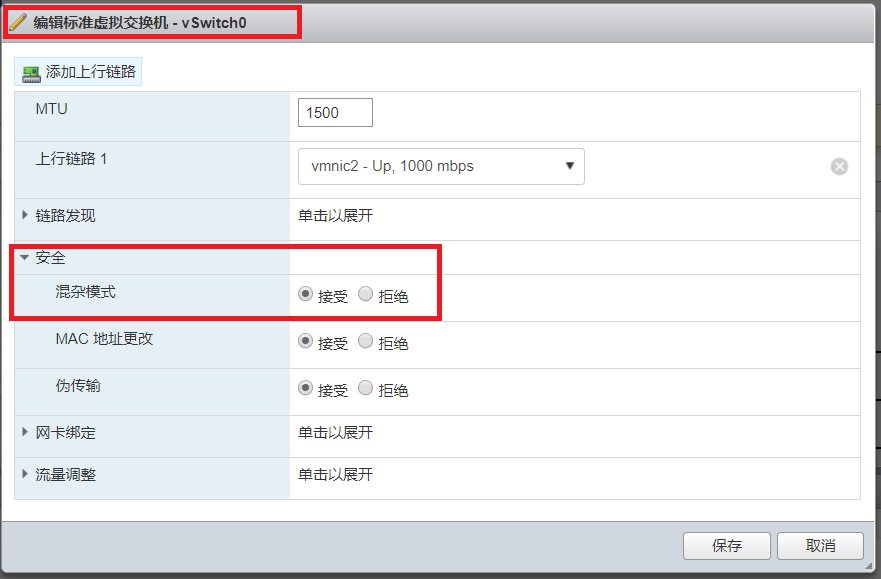

检查确认各个 CVM 之间是否可以 ping 通,注意,如果你发现AVH之间可以ping通,但是CVM无法与其它IP地址之间ping通。这是因为我们的部署环境属于嵌套虚拟机形式,这就需要在ESXi中开启端口的“混杂模式”。

开启混杂模式

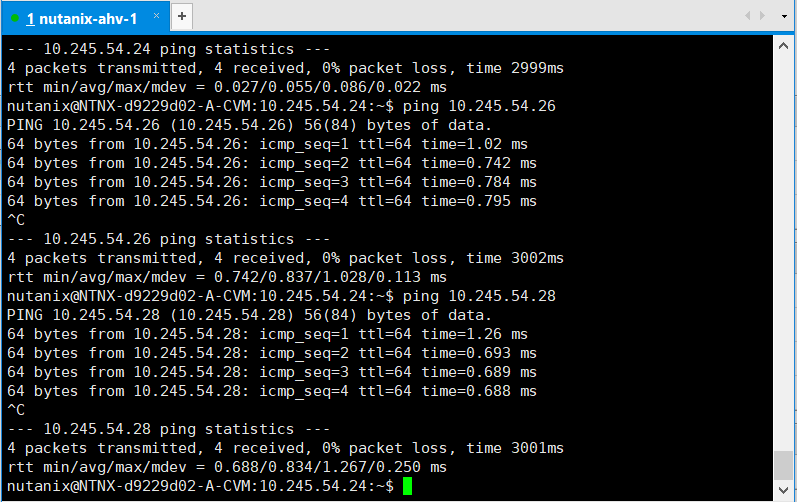

确认CVM之间可以Ping通

六,创建集群

经过上面的所有准备,现在我们的实验环境已经可以正式创建Nutanix-CE 集群了。

注:以下截图来自另外一套Nutanix-CE 集群,所以IP地址与前面章节中有所不同

6.1 登陆到CVM内部

这里我们选择登陆到node-01的CVM中

6.2 创建集群

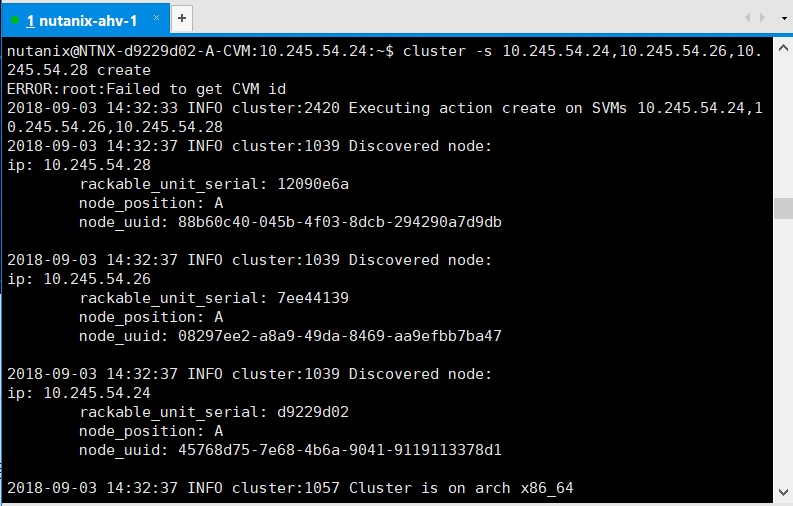

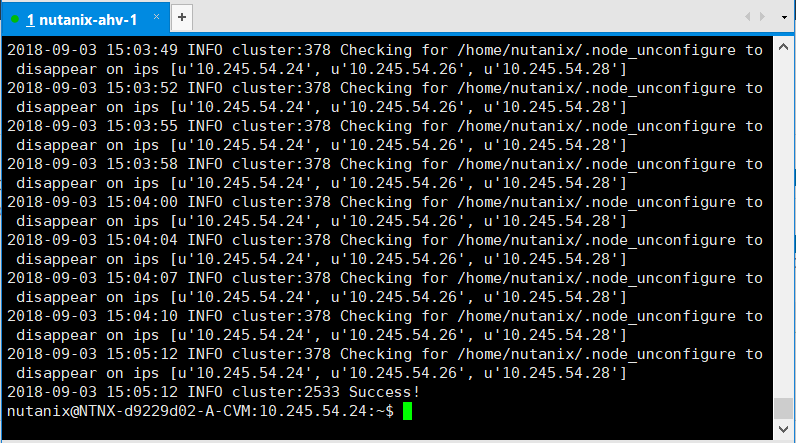

在node-01节点的CVM上执行以下命令:

cluster –s 10.245.54.24,10.245.54.26,10.245.54.28 create

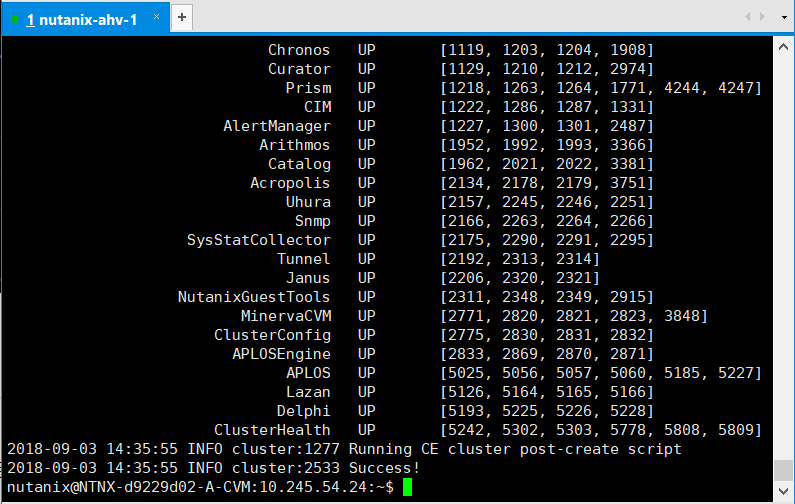

等待集群创建成功

6.3 检查集群状态

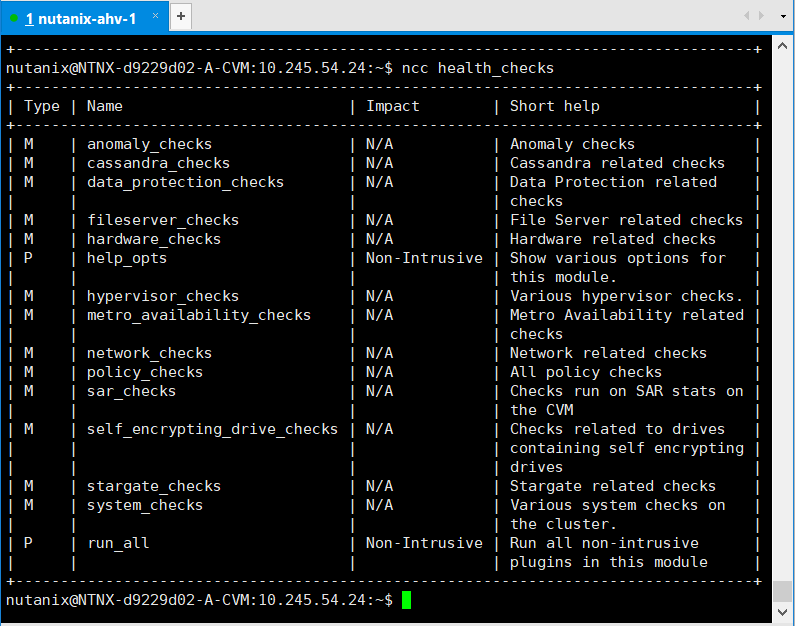

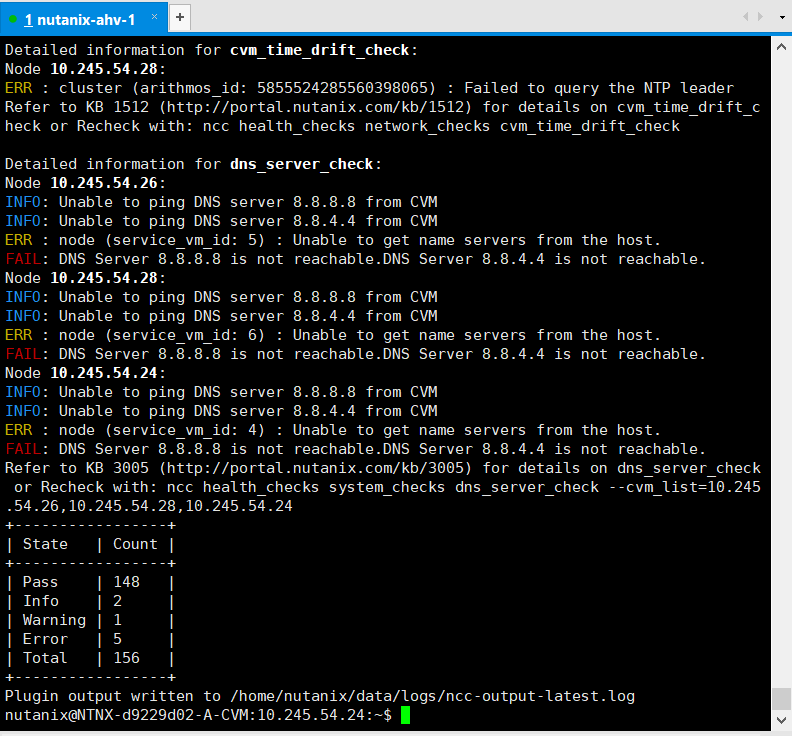

集群创建完毕以后,使用NCC命令查看集群健康状态

ncc health_checks 的检查项目如下:

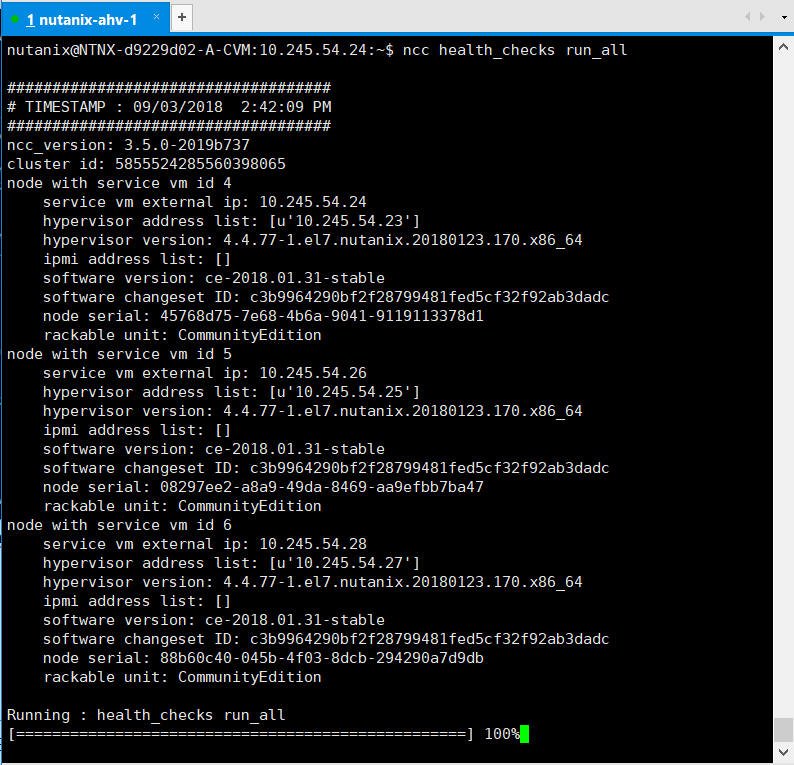

这里我们使用ncc health_checks run_all进行全面检查

检查结果:

从以下的检查结果中可以看到,集群无法正常访问DNS服务,还有NTP服务。这会导致这个集群无法使用my.nutanix.com的账号激活CE,因为激活需要访问互联网。所以,在规划部署时,要保证部署环境可以访问互联网。

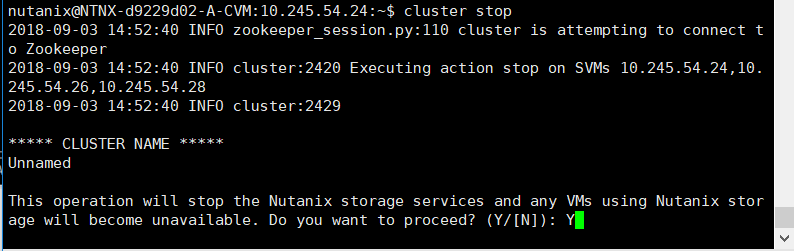

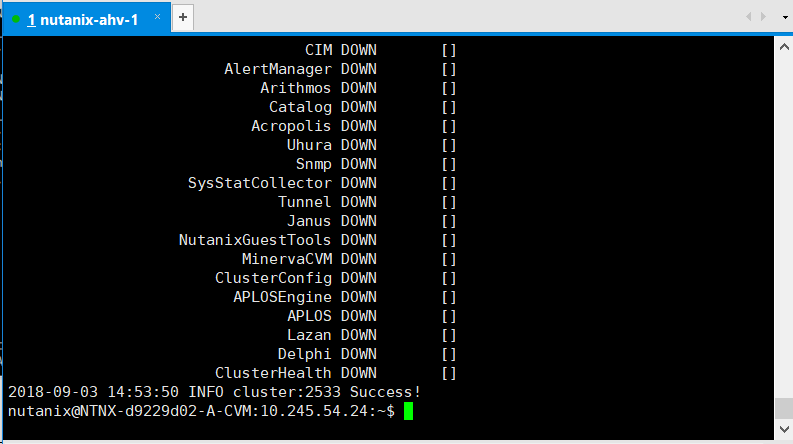

6.4 停止集群服务

使用cluster stop 命令可以停止集群服务。注意,如果集群中有远行的VM,需要先将其关机,否则集群无法停止。

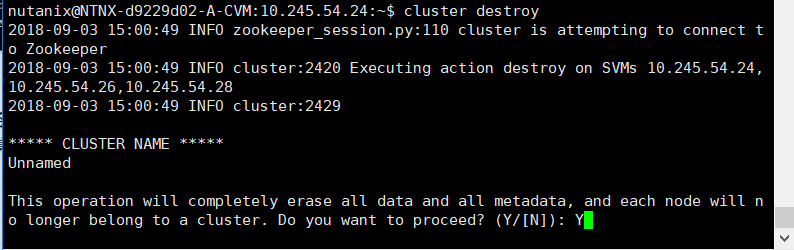

6.5 删除集群

使用cluster destroy 命令可以停止集群服务,如果配置有问题或者需要重建集群,可以使用此命令操作。删除集群后,集群中的所有数据都将被删除,包括虚拟机。

6.6 添加DNS和NTP

ncli cluster add-to-name-servers servers=x.x.x.x

ncli cluster add-to-ntp-servers servers=x.x.x.x,y.y.y.y

ncli cluster get-ntp-servers

allssh ntpq -pn

到这里Nutanix-CE集群就已经建立成功了。